自分のツイートを評価してみる作業

さて、PN Tableを使って自分のツイートを実際に評価してみます。

今回は、とりあえず何となく数値っぽいものを計算するところまで行きたかったので、単純な処理だけやりました。

前回のエントリでも使いましたが、自分のツイート全件を処理するときは、Twitterの公式サイトからダウンロードできる全ツイート履歴のCSVファイルを使うのが良いです。

これをPandasのデータフレームとして取り込むところから分析がスタートします。各種モジュールも最初にインポートしておきます。

import re

import csv

import time

import pandas as pd

import matplotlib.pyplot as plt

import MeCab

import random

tw_df = pd.read_csv('tweets.csv', encoding='utf-8')

このテーブルには、

- tweet_id # ツイートごとのID(いわゆるstatus_id)

- in_reply_to_status_id

- in_reply_to_user_id

- timestamp # 投稿日時

- source # 投稿に用いたデバイス

- text # 本文

- retweeted_status_id

- retweeted_status_user_id

- retweeted_status_timestamp

- expanded_urls # リンクが貼られている場合の、省略しない形のURL

という10個のフィールドがありますが、今回必要とするのはtweet_idとtextだけです。

次に、PN TableもPandasで読み込みます。先ほども例示したように、

めでたい:めでたい:形容詞:0.999645

賢い:かしこい:形容詞:0.999486

善い:いい:形容詞:0.999314

適す:てきす:動詞:0.999295

過小:かしょう:名詞:-0.942846

塗る:ぬる:動詞:-0.943453

器量負け:きりょうまけ:名詞:-0.943603

固まる:かたまる:動詞:-0.943991

というような内容になっているので、read_csvのオプションで区切り文字を「:」と指定して読み込めばいいかと思います。*1

pn_df = pd.read_csv('dictionary/PN_Table/pn_ja.dic.txt',\

sep=':',

encoding='utf-8',

names=('Word','Reading','POS', 'PN')

)

まず、個々のツイートをMeCabで形態素解析して、単語に分けるとともにその基本形表記を取得します。MeCabの導入方法等は過去のエントリを参照してください。

基本形を取得するのは、実際のツイート中に登場する未然形や連用形のように活用された形だと、極性辞書をサーチすることができないからです。

MeCab Pythonでふつうに形態素解析をする場合、返ってくる情報は以下のような感じになります。

>>> print(m.parse('STAP細胞はあります。'))

STAP 名詞,固有名詞,組織,*,*,*,*

細胞 名詞,一般,*,*,*,*,細胞,サイボウ,サイボー

は 助詞,係助詞,*,*,*,*,は,ハ,ワ

あり 動詞,自立,*,*,五段・ラ行,連用形,ある,アリ,アリ

ます 助動詞,*,*,*,特殊・マス,基本形,ます,マス,マス

。 記号,句点,*,*,*,*,。,。,。

EOS

1行1語になっていることが分かります。最後にEOSという終了記号が付いて、さらに空行が1行ついてきます。

これを後々どうやって扱うかなのですが、とりあえず私は深く考えずに、各行をdict型のデータに格納して、リストで連結しておくことにしました。

m = MeCab.Tagger('')

def get_diclist(text):

parsed = m.parse(text)

lines = parsed.split('\n')

lines = lines[0:-2]

diclist = []

for word in lines:

l = re.split('\t|,',word)

d = {'Surface':l[0], 'POS1':l[1], 'POS2':l[2], 'BaseForm':l[7]}

diclist.append(d)

return(diclist)

これによって、1つのツイート本文が以下のような情報に変換されます。見やすくするために改行を入れますが、

[

{'POS': '固有名詞', 'POS1': '名詞', 'BaseForm': '*', 'Surface': 'STAP'},

{'POS': '一般', 'POS1': '名詞', 'BaseForm': '細胞', 'Surface': '細胞'},

{'POS': '係助詞', 'POS1': '助詞', 'BaseForm': 'は', 'Surface': 'は'},

{'POS': '自立', 'POS1': '動詞', 'BaseForm': 'ある', 'Surface': 'あり'},

{'POS': '*', 'POS1': '助動詞', 'BaseForm': 'ます', 'Surface': 'ます'},

{'POS': '句点', 'POS1': '記号', 'BaseForm': '。', 'Surface': '。'}

]

こういう感じのリストです。

品詞は何かに使うかもと思って一応取得したんですが、結局今回は使いませんでした。しかし修正するのが面倒なのでこのままにしておきます。

あとで拡張していく時にも使うかもしれません。実際、1つの文章を形態素解析して「辞書のリスト」にすることにしておけば、後で色々使いまわせるような気もします。

次に、上で得られた単語ごとのdict型データに、PN Tableから取った極性値を項目として追加したいと思います。

最初にPN TableをPandasデータフレームとして読み込んであったので、ふつうに考えたらこのデータフレームを検索してPN値を取ってくればいいということになります。

たとえば、

pn_df.loc[pn_df.Word == '細胞', 'PN']

というような処理を繰り返せばPN値は取得してこれるのですが、この方法だと死ぬほど時間がかかります。

最初、この方法で1万3000件のツイートの解析をやってみたのですが、CPU使用率が98.8%になり、処理がなかなか終わりませんでした。シャドウバースを2試合やっても終わらなかったので、外に出て剣道の素振りをして帰ってきたらようやく終わっていました。なので、たぶん30分以上はかかったと思います。

そこで、Pandasのデータフレームを文字列で検索するのは非常に時間がかかるので、PN Table自体を{'単語':PN値, '単語':PN値, '単語':PN値...}という形のdict型データに変換した上で、単語をキーとしてアクセスしてPN値を取ってくる方法に変更したら約8秒で終わりました。8分ではなく8秒です。30分→8秒(約200倍速)。

また、感情辞書をこういう形にしておくことにすれば、他の辞書を使った分析へと拡張するのもやりやすいような気がしました。

word_list = list(pn_df['Word'])

pn_list = list(pn_df['PN'])

pn_dict = dict(zip(word_list, pn_list))

def add_pnvalue(diclist_old):

diclist_new = []

for word in diclist_old:

base = word['BaseForm']

if base in pn_dict:

pn = float(pn_dict[base])

else:

pn = 'notfound'

word['PN'] = pn

diclist_new.append(word)

return(diclist_new)

PN Tableに載っていない語をどうするかなのですが、今回は分析から除くことにしました。ゼロを割り当ててしまうとPN Table上で実際にゼロちょうどと評価されている単語(「週末」「巨体」「セレナーデ」など20語ある)なのか、載ってなかった単語なのかの区別がつかないので、適当にnotfoundと書いておきました。

これで各ツイートが以下のような形式のデータになります。

>>> test_text = 'STAP細胞はあります。'

>>> dl_test = get_diclist(test_text)

>>> dl_test = add_pnvalue(dl_test)

>>> print(dl_test)

[

{'PN': 'notfound', 'POS': '固有名詞', 'POS1': '名詞', 'BaseForm': '*', 'Surface': 'STAP'},

{'PN': -0.746254, 'POS': '一般', 'POS1': '名詞', 'BaseForm': '細胞', 'Surface': '細胞'},

{'PN': 'notfound', 'POS': '係助詞', 'POS1': '助詞', 'BaseForm': 'は', 'Surface': 'は'},

{'PN': 'notfound', 'POS': '自立', 'POS1': '動詞', 'BaseForm': 'ある', 'Surface': 'あり'},

{'PN': 'notfound', 'POS': '*', 'POS1': '助動詞', 'BaseForm': 'ます', 'Surface': 'ます'},

{'PN': 'notfound', 'POS': '句点', 'POS1': '記号', 'BaseForm': '。', 'Surface': '。'}

]

あとはPN値の平均をとるだけ(上記の文だとPN値を持った語が1つしかありませんが)なので、正直こんなゴツい形式のデータにする必要なかったと思いますが、先ほども述べたように「何かに使うかも」と思った経緯からこんな形になっております。

def get_pnmean(diclist):

pn_list = []

for word in diclist:

pn = word['PN']

if pn != 'notfound':

pn_list.append(pn)

if len(pn_list) > 0:

pnmean = mean(pn_list)

else:

pnmean = 0

return(pnmean)

全部notfound、つまりPN Tableに載っている単語を1語も含まないツイートを0点と評価するのはよく考えたら適切ではなく、分析から除外すべきですが、やりなおしが面倒なのでコードはこのままにしておきますw

ここまでできれば、あとはツイートの1件1件に対して、「形態素解析」「PN値の追加」「PNの平均値の算出」を繰り返していき、1つのリストにまとめます。

start_time = time.time()

pnmeans_list = []

for tw in tw_df['text']:

dl_old = get_diclist(tw)

dl_new = add_pnvalue(dl_old)

pnmean = get_pnmean(dl_new)

pnmeans_list.append(pnmean)

print(time.time() - start_time)

これを、ツイート全件履歴データフレームの右端に追加して、PN極性値でソートし、CSVで吐き出します。

text_list = list(tw_df['text'])

for i in range(len(text_list)):

text_list[i] = text_list[i].replace('\n', ' ')

aura_df = pd.DataFrame({'tweet_id':tw_df['tweet_id'],

'text':text_list,

'PN':pnmeans_list,

},

columns=['tweet_id', 'text', 'PN']

)

aura_df = aura_df.sort_values(by='PN', ascending=True)

aura_df.to_csv('aura.csv',\

index=None,\

encoding='utf-8',\

quoting=csv.QUOTE_NONNUMERIC\

)

結果をみてみる

さてどんな結果が得られたのかみてみたいと思います。

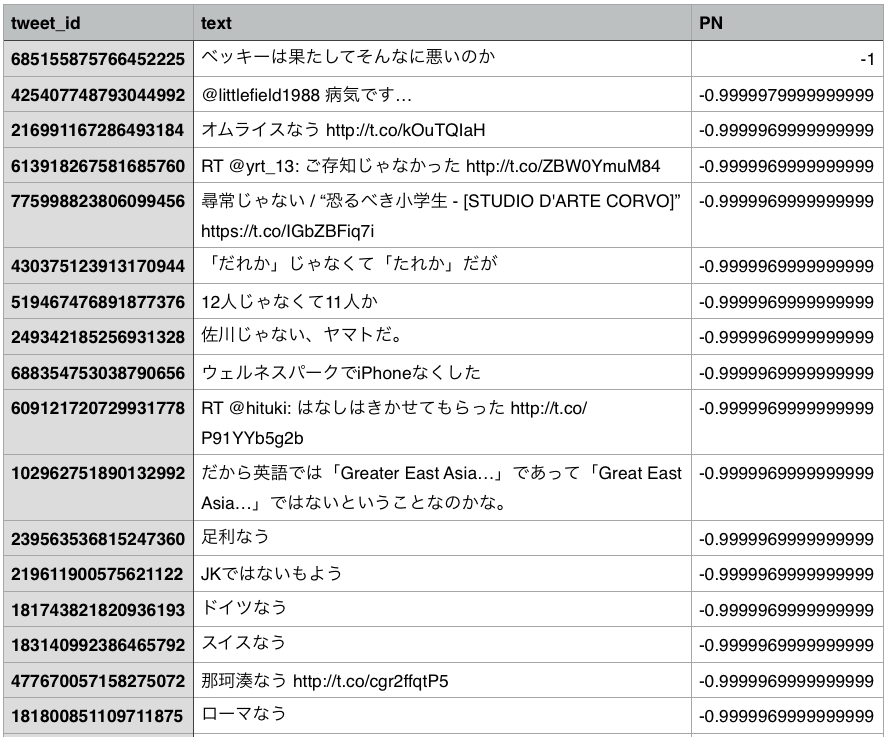

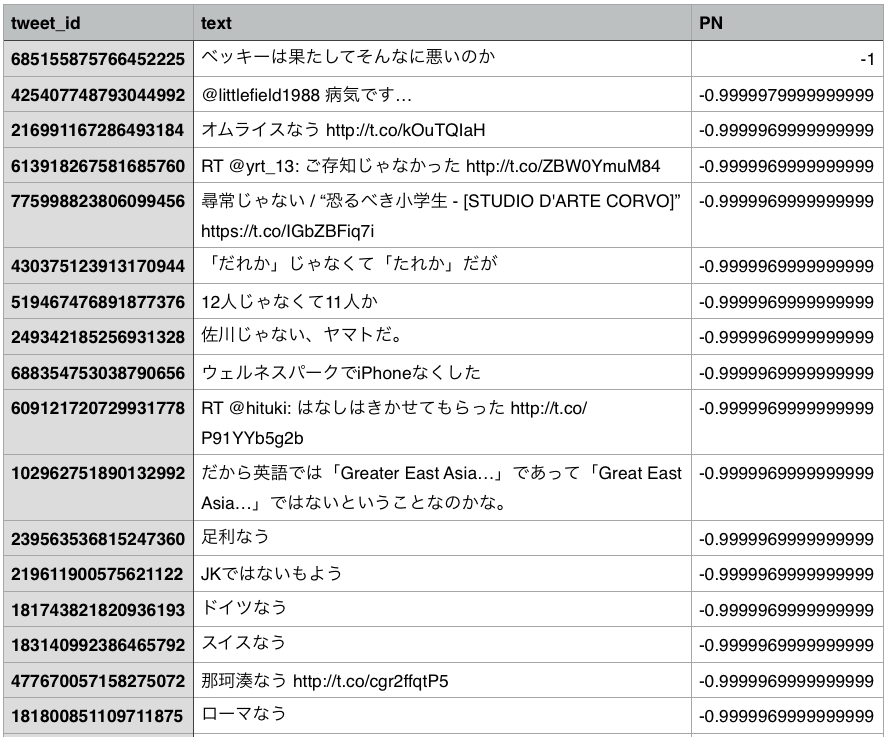

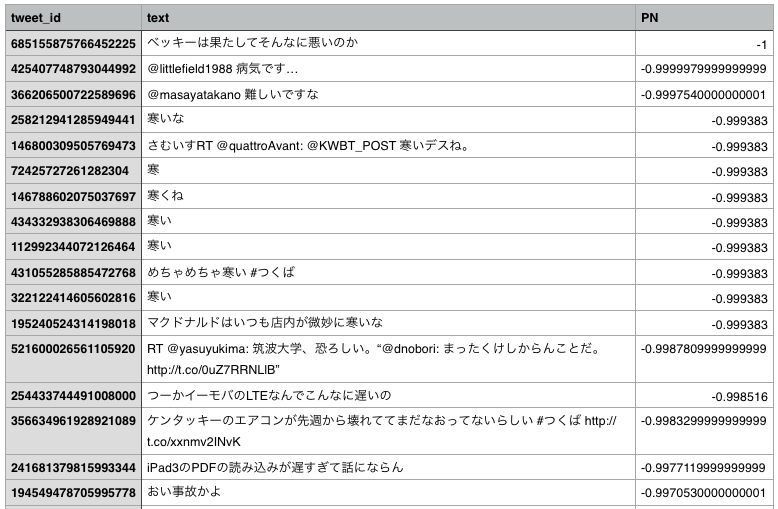

まずは、最もネガティブな方から十数件をみてみますと、

ベッキーさんの不倫事件を擁護しているツイートが最もネガティブという判定になりました。いきなり誤評価です。

なんでこんなことになったのか確認してみます。

>>> test_text = 'ベッキーは果たしてそんなに悪いのか'

>>> dl_test = get_diclist(test_text)

>>> dl_test = add_pnvalue(dl_test)

>>> for w in dl_test:

... print(w)

...

{'PN': 'notfound', 'POS': '一般', 'POS1': '名詞', 'BaseForm': '*', 'Surface': 'ベッキー'}

{'PN': 'notfound', 'POS': '係助詞', 'POS1': '助詞', 'BaseForm': 'は', 'Surface': 'は'}

{'PN': 'notfound', 'POS': '一般', 'POS1': '副詞', 'BaseForm': '果たして', 'Surface': '果たして'}

{'PN': 'notfound', 'POS': '一般', 'POS1': '副詞', 'BaseForm': 'そんなに', 'Surface': 'そんなに'}

{'PN': -1.0, 'POS': '自立', 'POS1': '形容詞', 'BaseForm': '悪い', 'Surface': '悪い'}

{'PN': 'notfound', 'POS': '非自立', 'POS1': '名詞', 'BaseForm': 'の', 'Surface': 'の'}

{'PN': 'notfound', 'POS': '副助詞/並立助詞/終助詞', 'POS1': '助詞', 'BaseForm': 'か', 'Surface': 'か'}

要するに、このツイートのなかでPN Tableに載っていた単語が「悪い」しかなく、「悪い」はPN Table上では最もネガティブな語ということになっているので、最もネガティブなツイートという判定になったわけですね。

そもそもこの文、「か」を付けた反語になっているわけですが、このように文法構造を無視して単語だけで評価すると無理があるということが、この1例からも分かります。

「良くない」とか「優れていないというわけでもない」みたいな表現を的確に評価しようと思ったら、「良い」「優れる」の部分だけみるのではなく、例えば係り受け解析というのを行って、これらの表現が打ち消されたりしていないかをきちんと調べないといけません。

係り受け解析にはCaboChaというツールがありますので、これは後日また使ってみようかと思います。

また、「オムライスなう」がなぜネガティブな評価になるのかというと、

>>> test_text = 'オムライスなう'

>>> dl_test = get_diclist(test_text)

>>> dl_test = add_pnvalue(dl_test)

>>> for w in dl_test:

... print(w)

...

{'PN': 'notfound', 'POS': '一般', 'POS1': '名詞', 'BaseForm': 'オムライス', 'Surface': 'オムライス'}

{'PN': -0.9999969999999999, 'POS': '自立', 'POS1': '形容詞', 'BaseForm': 'ない', 'Surface': 'なう'}

このように、「なう」が形容詞の「ない」として判定されており、ないは否定的な言葉なので、ネガティブな評価となってしまってるわけです。上の出力には出てませんが、別途確認したら「連用ゴザイ接続」という活用形として判定されてました。

「なう」は一つの典型例ですが、要するにTwitter独自の表現を辞書に取り込まないと、適切に評価できないことが分かります。

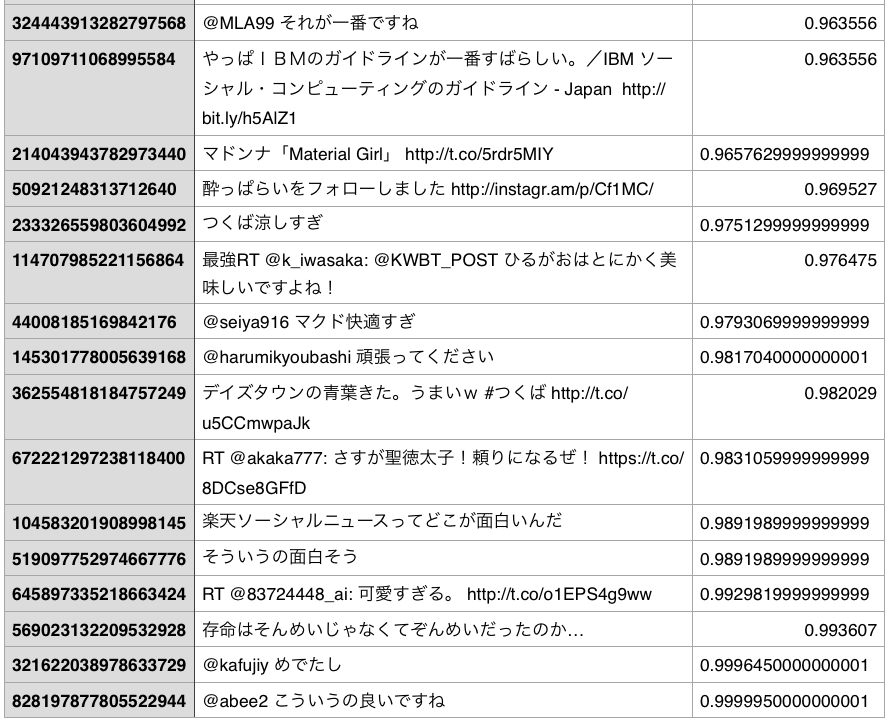

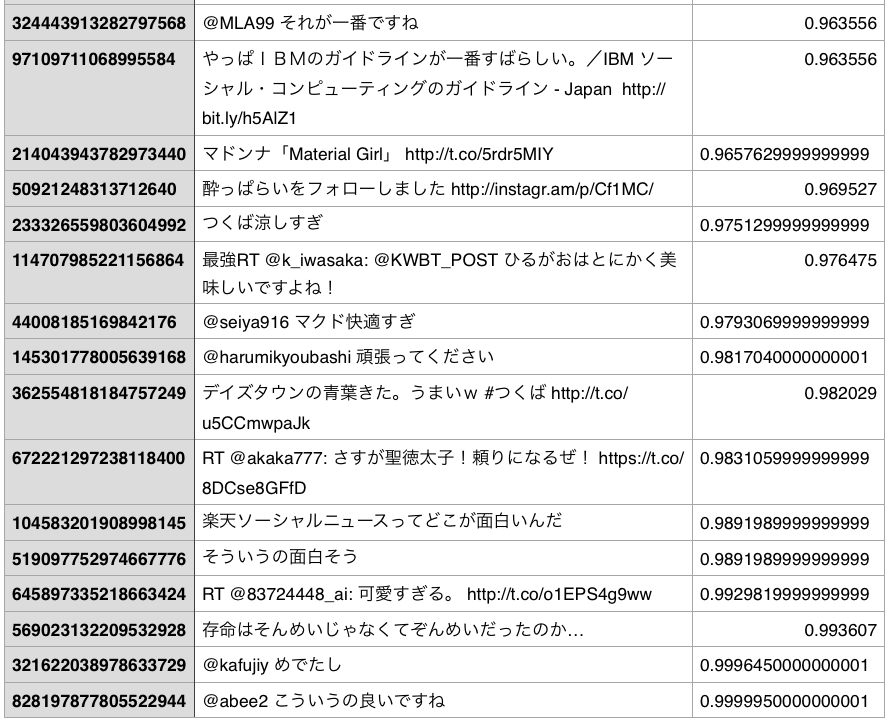

つぎにポジティブなほうから十数件をみてみましょう。

これはネガティブ側に比べれば比較的当たってる気もしますが、「楽天ソーシャルニュースってどこが面白いんだ」のように、反語的な表現が適切に評価できていないのは先ほどみたのと同じですね。

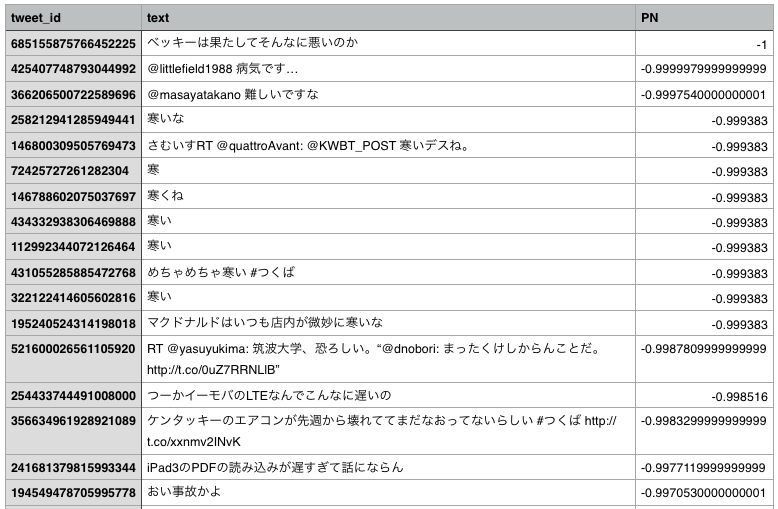

「ない」の扱いはややこしいので、ややこしい処理を実装すべきなんですが、試しに逆に「ない」を辞書から削除して分析してみたらネガティブランキングは以下のようになりました。

rem_ix = list(pn_df[pn_df.Word == 'ない'].index)

pn_df = pn_df.drop(rem_ix)

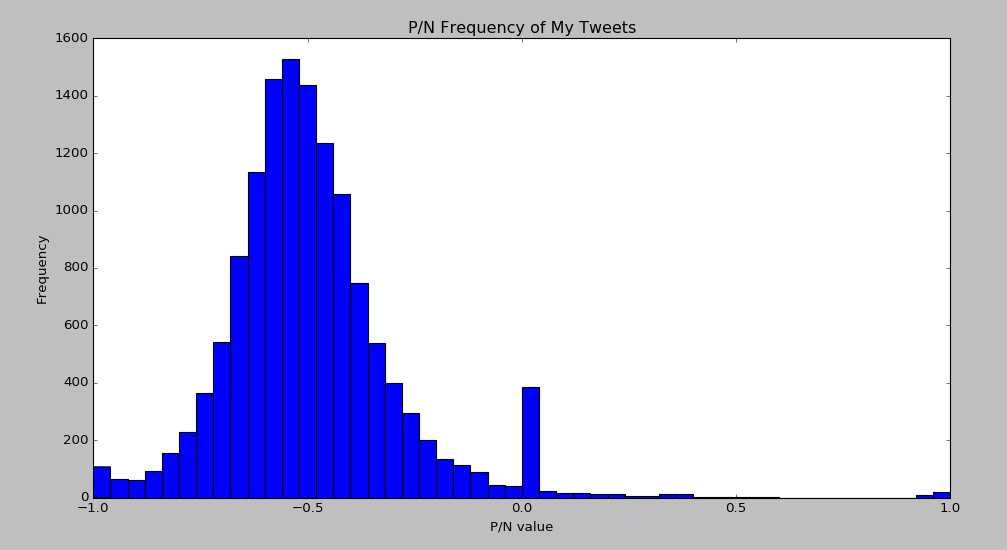

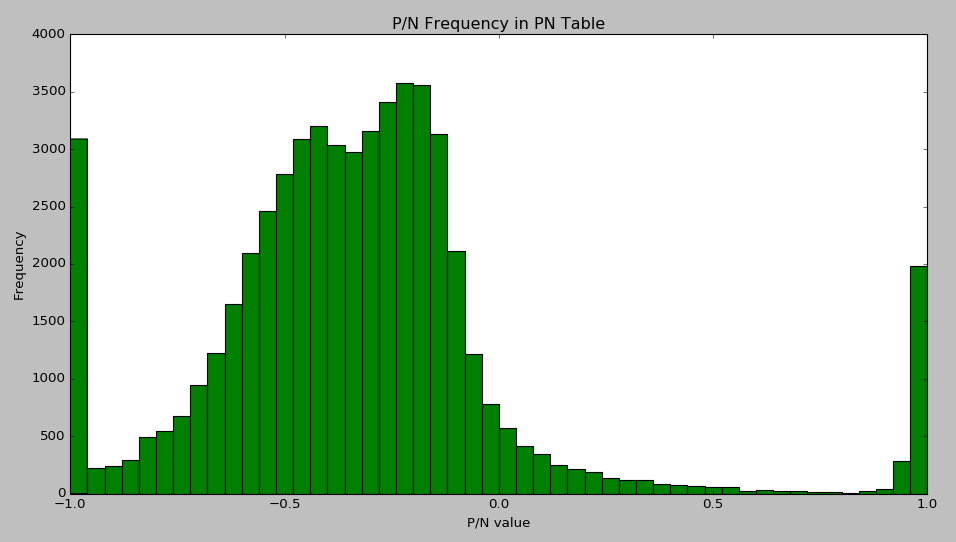

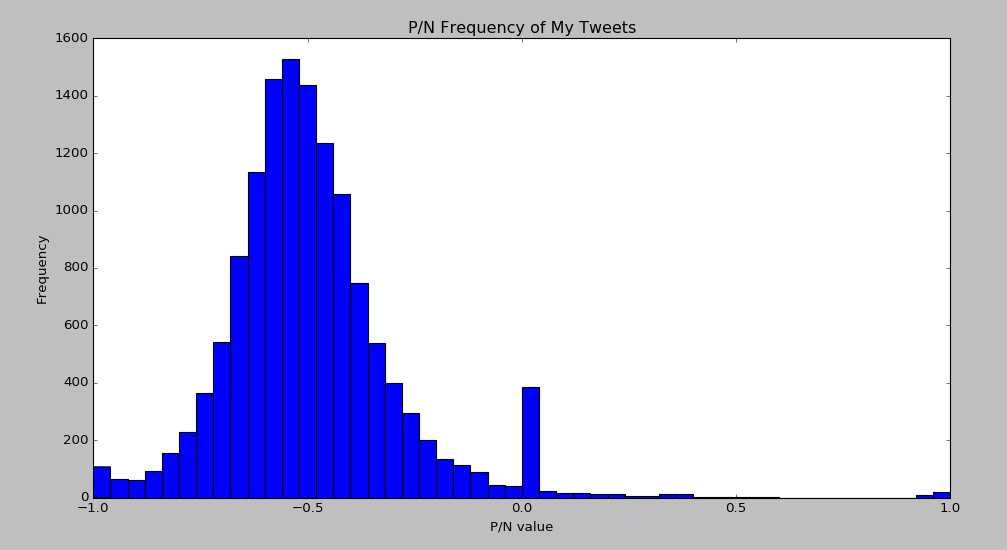

次に、全体として極性値の分布がどうなっているのかをみてみます。

matplotlibでヒストグラムを描きます。

x1 = list(aura_df['PN'])

plt.hist(x1, bins=50)

plt.title('P/N Frequency of My Tweets')

plt.xlabel("P/N value")

plt.ylabel("Frequency")

全体的に、負の値に偏っています。ゼロのところに山ができているのは、上述のとおりPN Tableに載っている単語を1語も含まないツイートが0点と評価されてるからで、これは適切な処理ではないので無視してください。

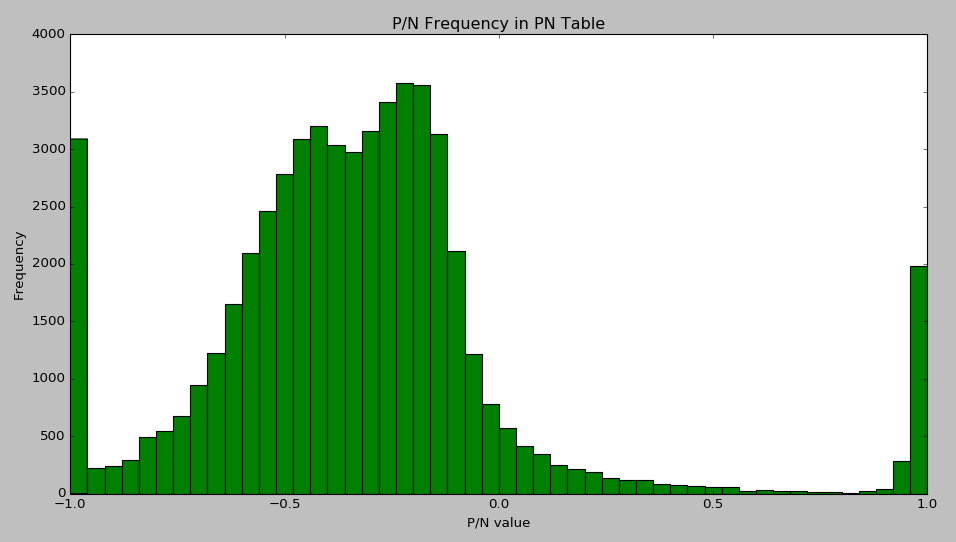

ところでこの結果が、ネガティブなツイートが多いことを意味しているのかというと、そうでもない可能性があります。というのも、PN Table自体のヒストグラムも取ってみると、

x2 = list(pn_df['PN'])

plt.hist(x2, bins=50)

plt.title('P/N Frequency in PN Table')

plt.xlabel("P/N value")

plt.ylabel("Frequency")

こんなふうになっており、そもそも大半が負の値を持つ語であるということが分かります。そういう、辞書のクセなんでしょうが、結局どのへんがニュートラルなのかはよく分かっておりません。